连日来实现AI的未来将需要极大地扩展AI计算的规模 向来一不断的有小伙伴关注,不仅如此还衍生出了各大相关话题,那么跟着小编来看看实现AI的未来将需要极大地扩展AI计算的规模 以及它的相关资讯吧!

想象一下个性化人工智能(AI),您的智能手机变得更像是智能助手–即使在嘈杂的房间中也能识别您的声音,了解不同社交环境的背景或仅呈现与您真正相关的信息每天收到的数据 此类功能可能很快就会触手可及-但要实现此功能,将需要快速,强大,节能的AI硬件加速器。

在最近发表在《自然》上的一篇论文中,我们的IBM Research AI团队演示了使用与基于图形处理单元(GPU)的系统相同的精度的大型模拟存储设备进行的深度神经网络(DNN)培训。我们认为,这是通往下一个AI突破所必需的硬件加速器之路的重要一步。为什么?因为实现AI的未来将需要极大地扩展AI计算的规模。

无论在云端还是在边缘,DNN都必须变得更大,更快。这意味着能源效率必须大大提高。虽然更好的GPU或其他数字加速器可以在一定程度上有所帮助,但此类系统不可幸免地会花费大量时间和精力将数据从内存转移到处理和返回。我们可以直接在数据位置执行模拟域中的AI计算,从而提高速度和能源效率-但这仅在最终的神经网络与常规数字硬件实现的神经网络一样智能的情况下才故意义。

涉及延续可变信号而不是二进制0和1的模拟技术对其精度具有固有的限制,这就是现代计算机通常是数字计算机的原因。但是,人工智能研究人员已经开始意识到,即使将数字精度降低到几乎对任何其他计算机应用程序来说都太低的水平,他们的DNN模型仍然可以正常工作。因此,对于DNN,也许模拟计算也可能起作用。

但是,直到现在,还没有人最终证明这种模拟方法可以与当今在常规数字硬件上运行的软件做同样的工作。也就是说,可以使用这些技术将DNN真正训练成具有相同的高精度吗?如果最终的分类精度始终低得令人无法接受,那么在训练DNN时就没有更快或更节能的意义。

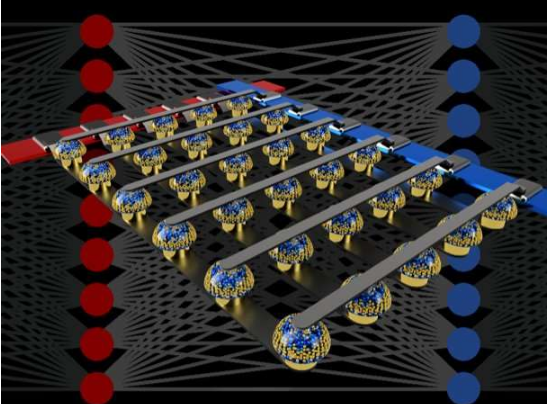

在我们的论文中,我们描述了模拟非易失性存储器(NVM)如何能够有效地加速许多最新AI进步的核心“反向传播”算法。这些存储器同意 使用基础物理学在权重数据位置的模拟域中并行化在这些算法中使用的“乘法累加”运算。我们无需通过大型电路来将数字数字相乘和相加,而是简单地将一小电流通过电阻流经电线,然后将多条这样的电线连接在一起以使电流积聚。这使我们可以同时执行许多计算,而不是一个接一个地执行。而且,我们可以在模拟存储芯片内部执行所有计算,而不必在数字存储芯片和处理芯片之间进行长途运输时传送数字数据。

但是,由于当今模拟存储设备固有的各种缺陷,以前在大型实际NVM设备阵列上直接进行DNN训练的演示未能实现与软件训练网络相匹配的分类精度。

通过将相变存储(PCM)器件中的长期存储,常规互补金属氧化物半导体(CMOS)电容器的近乎线性更新以及抵消器件间差异性的新颖技术相结合,我们对这些缺陷进行了精细化处理,并实现了在各种不同的网络上,软件等效的DNN的准确性。这些实验使用了混合的硬件-软件方法,将易于精确建模的系统元素(例如CMOS设备)的软件仿真与PCM设备的完整硬件实现相结合。对于我们的神经网络中的每个权重,都必须使用真实的模拟存储设备,因为此类新型设备的建模方法经常无法捕获它们可能展现出的所有设备间差异。

使用这种方法,我们验证了全芯片确实应该提供同等的精度,从而可以与数字加速器完成相同的工作-但速度更快且功耗更低。鉴于这些令人鼓励的结果,我们已经开始探究原型硬件加速器芯片的设计,这是IBM Research Frontiers Institute项目的一部分。

通过这些早期的设计工作,我们能够作为自然论文的一部分,以计算能效(28,065 GOP / sec / W)的形式提供此类基于NVM的芯片用于训练全连接层的潜力的初步估量。 )和单位面积的吞吐量(3.6 TOP / sec / mm2)。这些值超出当今GPU的规格两个数量级。此外,全连接层是神经网络层的一种类型,其实际GPU性能经常远远低于额定规格。

本文指出,尽管现有的模拟存储设备不完善,但基于NVM的方法仍可以提供等效于软件的训练精度,并在加速和能量效率方面提高了几个数量级。下一步将是在要求大型,全连接层的大型网络上演示相同的软件等效性,例如在机器翻译的最新发展背后的循环连接的长期短期内存(LSTM)和门控循环单元(GRU)网络,字幕和文本分析–并在基于NVM的原型硬件加速器上设计,实现和完善这些模拟技术。针对此应用进行了优化的新型更好形式的模拟存储器可以帮助进一步提高面密度和能效。